Файлы индексации: robots.txt и sitemap.xml — почему они так важны?

Чтобы покупатели могли найти ваш магазин в поисковых системах, он должен быть проиндексирован, т. е. программа-робот последовательно загрузит все страницы вашего сайта, проанализирует их и включит в поисковую выдачу.

Именно здесь и понадобится файл robots.txt — своеобразная инструкция, которая запрещает или разрешает роботу индексировать или не индексировать страницы определенным образом. Если такого файла на сайте нет, робот считает, что все содержимое сайта вы разрешаете просматривать и индексировать. А это опасно. Если не «спрятать» от робота папки и файлы административной части сайта, то магазин становится потенциально уязвим для хакерских атак. Усильте безопасность своих покупателей и своего бизнеса простым добавлением файла robots.txt.

Составление файла — достаточно простой и быстрый процесс для веб-мастера. Однако важно соблюсти правильный синтаксис, чтобы все команды, даваемые роботу, понимались им верно. Поэтому доверьте эту работу своему оптимизатору либо воспользуйтесь инструментами-помощниками, если вы решили сделать robots.txt самостоятельно.

Создание robots.txt вручную

Дополненный русский перевод официального сайта о robots.txt: http://robotstxt.org.ru/ , где можно найти простые инструкции и ответы на проблемные вопросы.

Автоматическое создание robots.txt

http://pr-cy.ru/robots/ — популярный инструмент для автоматического формирования файла.

Работа над ошибками

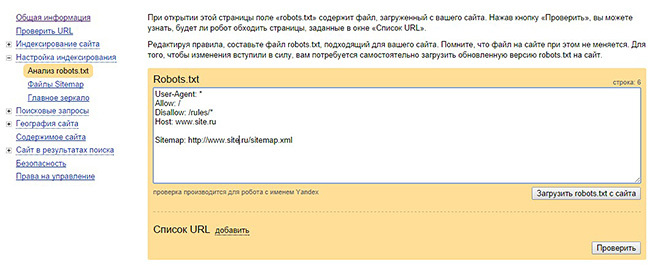

Инструмент от Яндекса: http://webmaster.yandex.ru/robots.xml#results — здесь можно проанализировать созданный файл и исправить возможные ошибки.

sitemap.xml своими руками

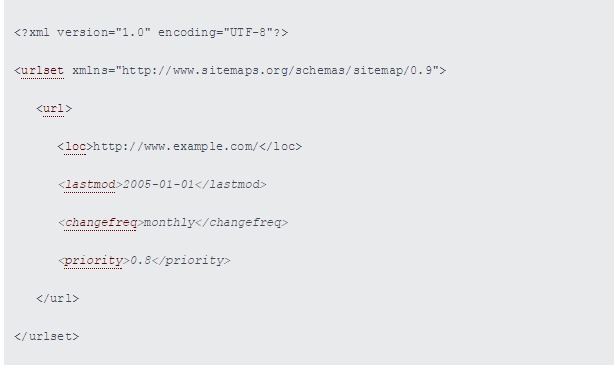

Файл sitemap.xml содержит список всех страниц сайта, подлежащих индексации. Казалось бы, поисковой робот должен самостоятельно найти все страницы, которые не спрятаны от него в robots.txt, но… Некоторые сайты (в том числе интернет-магазины) содержат большое количество динамических страниц, а некоторые находятся глубоко в структуре сайта, и робот может их не найти, если будет последовательно переходить с одной внутренней ссылки на другую.

Чтобы ничего не потерялось и не было упущено роботом, составляется карта сайта. Также она содержит ценные инструкции для роботов по частоте обновления страниц и их поисковой ценности (самые важные страницы будут проиндексированы в первую очередь). Кстати, именно в файле robots.txt необходимо указывать путь к директории, где лежит карта.

Автоматическое создание sitemap.xml

Много онлайн-сервисов автоматически формируют карту сайта, но не все из них бесплатные. Здесь http://www.cy-pr.com/tools/sitemap/ вы можете создать sitemap.xml быстро, надежно и абсолютно бесплатно.

Работа над ошибками

Результат своих трудов вы увидите в поисковой выдаче, просто набрав адрес вашего магазина в строке поиска. За небольшую плату (15 руб.) вы можете проверить уже готовый файл sitemap.xml на этом ресурсе http://htmlweb.ru/analiz/sitemap.php.

Проверить работу своего веб-мастера или застраховаться от распространенных ошибок вы можете, если заранее ознакомитесь с требованиями к файлу на официальном вики http://www.sitemaps.org/ru/faq.html. Например, карта не может «весить» больше 10 Мб и содержать более 50 000 ссылок.

Хочу все сразу!

Если вы не хотите тратить время своего веб-мастера на эту задачу, если вы хотите быть уверены, что все сделано правильно, с соблюдением стандартов и специфики вашего магазина, закажите у нас услугу SEO-старт. Специалисты Shop2you выполнят всю работу, а вы сможете сосредоточиться только на ведении бизнеса.

Обратите внимание, что SEO-старт — это комплексный пакет, в который включено не только создание файлов для роботов, но и другие жизненно важные для продвижения услуги: подбор ключевых слов, оптимизация заголовков и мета-тэгов, базовое продвижение в соцсетях, написание статей и др. Таким образом, вы получите не разрозненный набор выполненных задач, а целенаправленный комплекс начального продвижения.